Witam, zachęcony wrzutą użytkownika AstreaZero: https://jbzd.com.pl/obr/2678382/poradnik-jak-zmajstrowac-sobie-wlasna-ai-witkorianska-dziewczyne

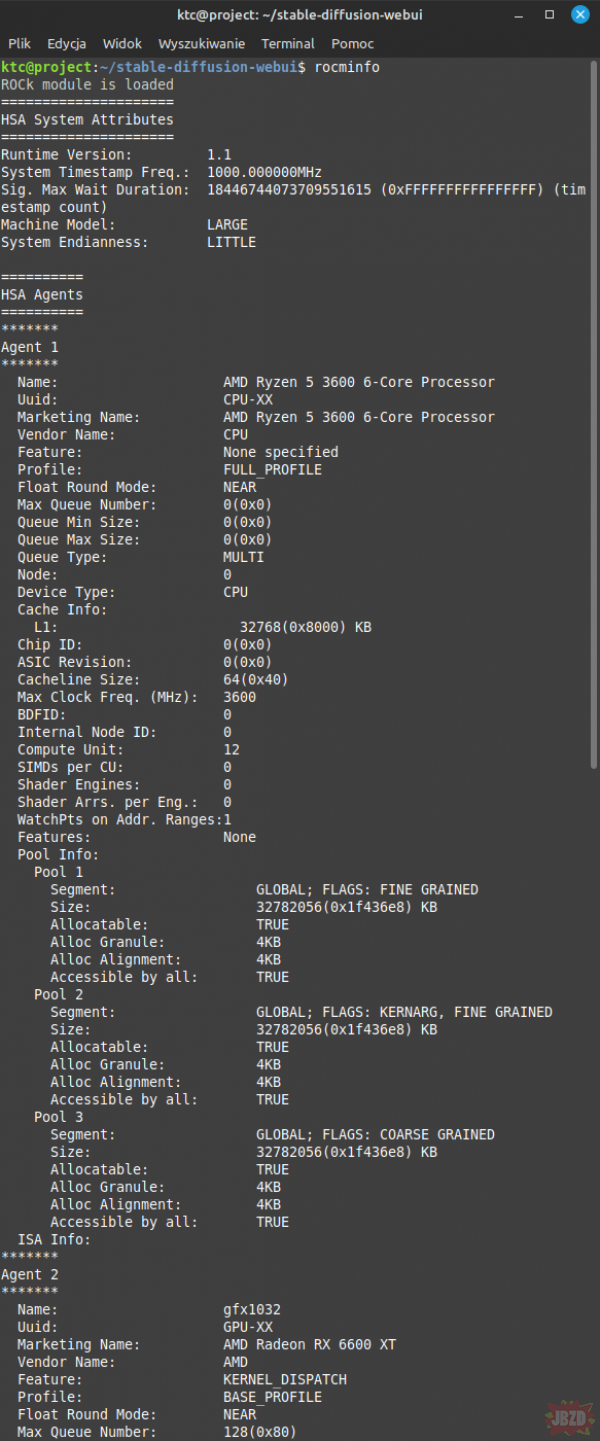

chciałem sam coś zmajstrować, niestety jako że używam karty graficznej od AMD to dany poradnik u mnie nie zadziała.

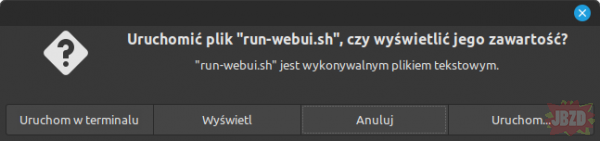

Udało mi się użyć Stable Diffusion na windowsie wykorzystując wersję direct-ml: https://github.com/lshqqytiger/stable-diffusion-webui-directml

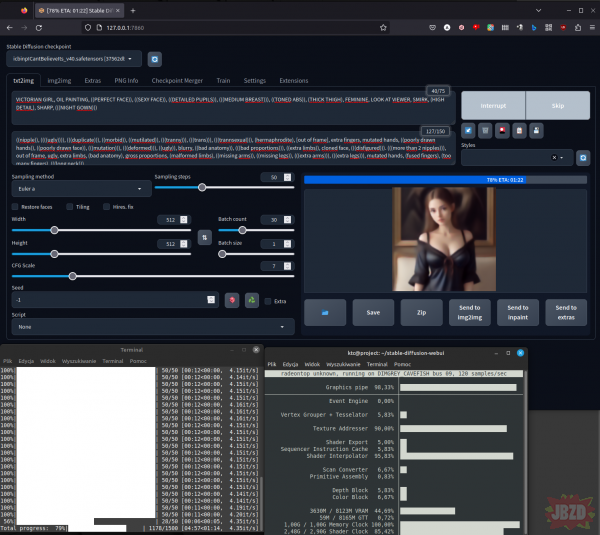

niestety jego wydajnośc na AMD jest dość niska, na mojej karcie graficznej RX6600 XT 8GB to zaledwie: 0.2it/s.

Jeste też wersja wykorzystująca Vulkan: https://github.com/nod-ai/SHARK

Wydajnośc znacznie lepsza bo nawet 2.4it/s, niestety jest ona mocno ograniczona, tzw. brak możliwości instalacji nowych modułów(controlnet, mov2mov itd.) a sama zmiana modelu do generacji obrazków trwa dobrych 10 minut.

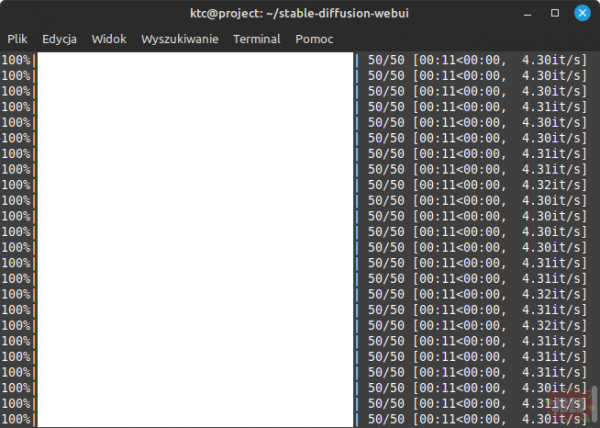

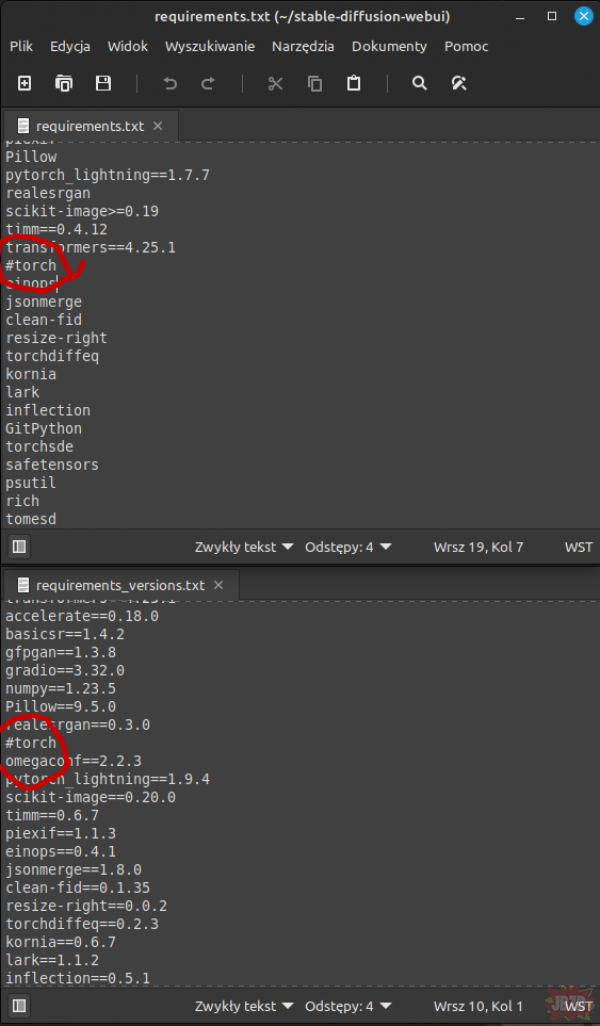

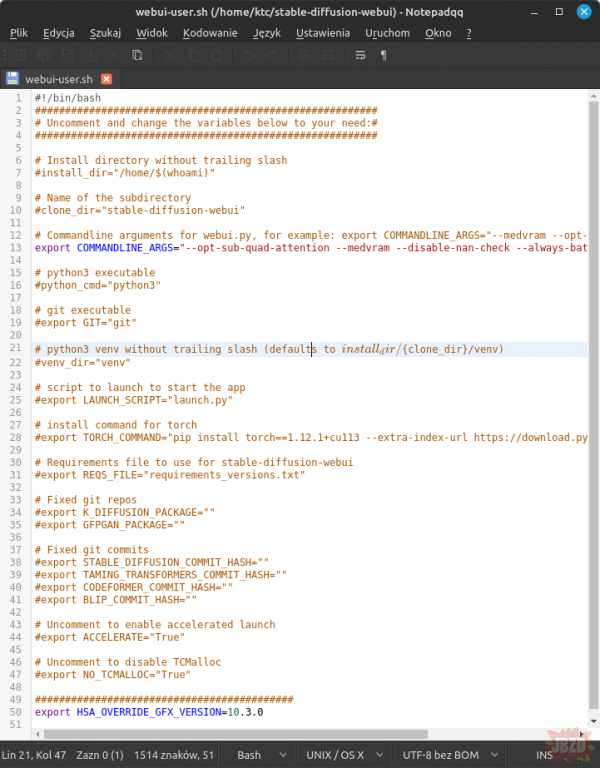

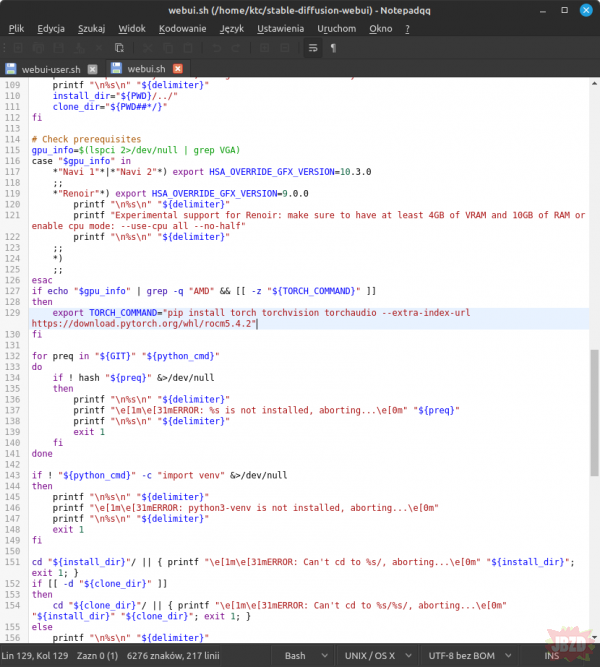

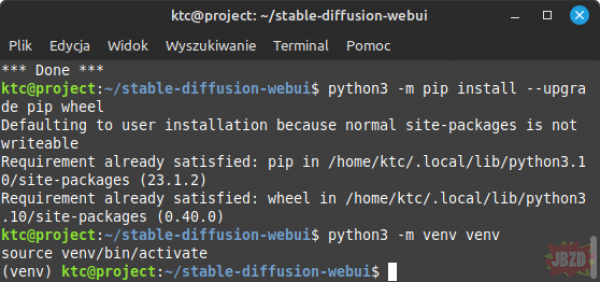

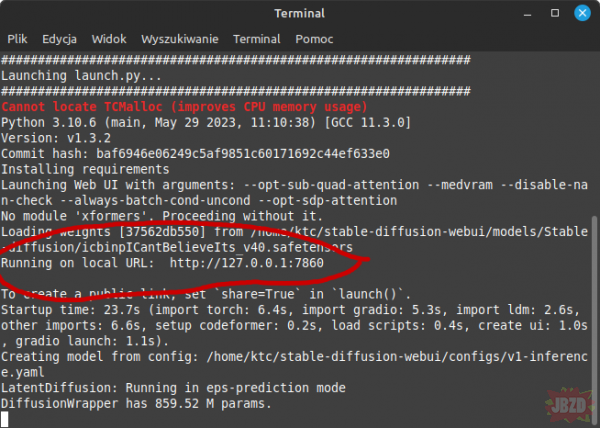

Okazuje się jednak że jakiś czas temu AMD zapewniło wspracie ROCM dla kart konsumenckich, coś ala CUDA od NVIDII, niestety narazie jedynie pod Linuxem. Na Linuxie udało mi się osiągnąć wydajność na poziomie 4.3-4.9it/s z zachowaniem wszystkich możliwości Stable Diffusion.